El uso de la Inteligencia Artificial en nuestras vidas ha provocado un aumento de preocupación tanto de los ciudadanos como de los gobiernos por crear algún tipo de regulación para controlar las herramientas y soluciones que se están creando a partir de ella.

Nuestra curiosidad nos ha llevado a querer conocer como es el proceso de creación de estas herramientas por parte de las empresas para facilitar el trabajo a otras. Un proceso que es lento y muy cuidadoso, porque no todas las soluciones se pueden crear, ya que muchas pueden estar enfocadas de forma que puedan llegar a infringir aspectos éticos.

Hemos visto en estos últimos meses como numerosas compañías han tenido que anunciar la suspensión de sus herramientas de IA, porque estaban empezando a infringir normas éticas. Entre estos casos nos encontramos con el de Amazon que tuvo que interrumpir el uso de un sistema de reclutamiento de candidatos después de descubrir que tenía un sesgo contra las candidatas femeninas, o uno de los casos más compartidos en las últimas semanas de los dispensadores de jabón que no dan jabón a las personas de raza negra.

¿Qué acuerdos se han firmado recientemente?

Los Gobiernos quieren regular este tipo de soluciones y herramientas, por eso, se está intentado crear comités y reglamentos que faciliten este proceso.

La Unión Europea el 19 de febrero anunció la publicación de su Libro Blanco sobre Inteligencia Artificial. Una aproximación Europea a la Excelencia y la Confianza. En él, querían aclarar algunos aspectos para conseguir dos objetivos muy importantes: promover la Inteligencia Artificial en Europa y prevenir los riesgos derivados de su uso.

En el mes de febrero también se reunieron dos grandes empresas tecnológicas como son IBM y Microsoft junto con el Vaticano para firmar una «resolución ética», junto con ellos también estuvo Qu Dongyu, El director general chino de la Organización de las Naciones Unidas para la Alimentación y la Agricultura. La promesa que firmaron estaba destinada a cumplir con la protección de los derechos de toda la humanidad, particularmente a los débiles y desfavorecidos, y sumar nuevas regulaciones en campos como el reconocimiento facial. Creen que las empresas deben dar explicaciones sobre cómo la IA toma las decisiones, cuáles son sus propósitos y objetivos.

El proceso que se sigue para crear herramientas de IA

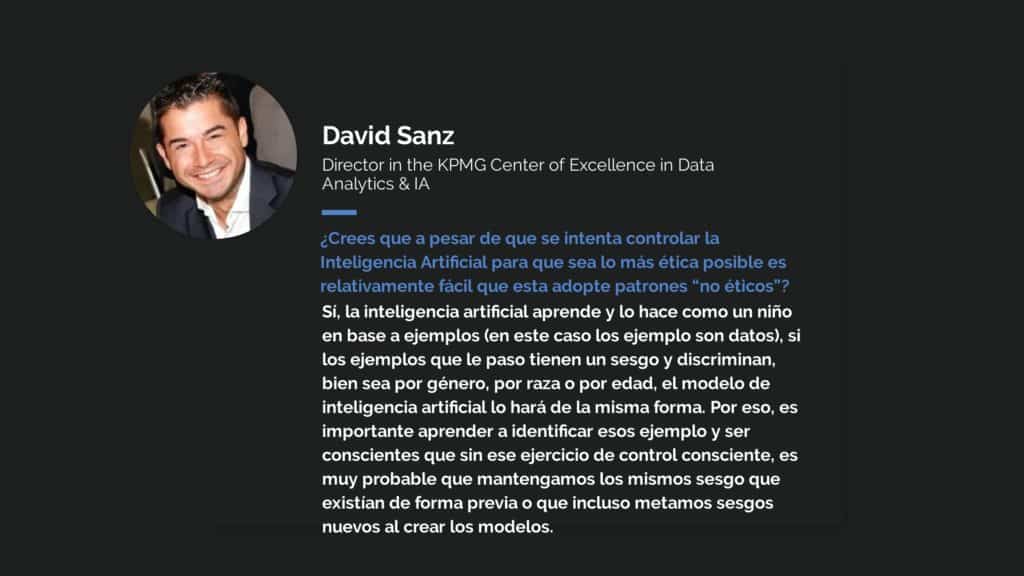

Contactamos con la consultora KPMG para que nos contará los pasos que ellos siguen cuándo inician un proyecto de Inteligencia Artificial.

Quisimos comenzar conociendo cómo se inician estos proyectos, David Sanz Díaz Director D&A e Inteligencia Artificial de KPMG, nos contó: «habitualmente la selección del caso de uso la hace el cliente en base al retorno de la inversión que tiene (Cuanto más ahorro mayor es la probabilidad de que salga el caso)«

¿Cuándo se detecta un error ético en la IA?

David nos contestó: «Cuando hacemos este tipo de proyectos, la identificación de un problema ético suele darse en alguno de estos dos momentos: cuando te plantean el caso de uso o cuándo analizar los datos para hacer los modelos.«

En el momento en el que te planteas un caso de uso para Sanz se entiende como un momento en el que te planteas, también, un caso de uso que te supone un dilema moral. Nos da los siguientes ejemplos:

- Hacer una clasificación de alumnos en base a la probabilidad de éxito en los estudios. Se esta clasificación y no es éticamente cuestionable, si utilizas la clasificación por ejemplo para apoyar con clases de refuerzo en los estudios. El problema surge si lo quieres utilizar en el proceso de admisiones en un colegio para solo quedarte con los alumnos que potencialmente tendrán mejor rendimiento escolar, es una proyecto cuestionable, que rechazarían por varios motivos: marcar a un niño es moralmente cuestionable; corres el riesgo de crear una profecía autocumplida, es decir, como le marco como de bajo éxito, le trato como tal y el resultado es que al final es de bajo éxito; y los resultados de los modelos no son infalibles, siempre tienes un % de error que estaría penalizando a estudiantes.

- Identificar pacientes crónicos que tendrán un ingreso hospitalario en los próximos 12 meses. En este caso no es éticamente cuestionable si utilizas esta información para poner en marcha un programa de atención a la cronicidad, donde focalizas recursos en estos pacientes para evitar su ingreso hospitalario, esto te permite mejorar la calidad de vida de los pacientes e incluso incrementar su esperanza de vida. Pero si lo quieres utilizar para evaluar su acceso a un seguro médico, es moralmente cuestionable, ya que si todas las aseguradoras de salud realizasen este ejercicio, este grupo de población podría quedarse sin asistencia sanitaria privada.

- Crear un algoritmo de clonación de voz, donde con unos segundos de tu voz es capaz de copiarla. No sería éticamente cuestionable si se utiliza este algoritmo para copiar la voz de pacientes que han perdido el habla, pero si por el contrario utilizo la clonación de voz para suplantar una identidad y realizar un fraude lo hace moralmente cuestionable.

La conclusión final que nos remarca Sanz con todo esto, es que la importancia en las soluciones de IA está en el uso que tú quieras hacer con ella.

El otro momento para el Director D&A e Inteligencia Artificial de KPMG en el que puedes identificar un problema ético en un proyecto es cuándo analizar los datos para hacer los modelos, porque puedes encontrarte con elementos que sesgan el modelo y podrías meter inconscientemente en el modelo un sesgo. Aquí nos expone los siguientes ejemplos:

- Hacer un modelo de preselección curricular de candidatos que te saque los 5 mejores de los miles que puede llegar una empresa a recibir. Este es un modelo que en principio no debería tener un problema ético incluso podría ayudar a reducir el sesgo del evaluador del CV al ver la foto, el nombre o la universidad en la que estudió. Pero si entrenamos un modelo con el histórico de CVs de los empleados que hemos tenido en la empresa e históricamente han sido mayoritariamente hombres, puedes incorporar un sesgo sexista, donde los hombres tengan mayor probabilidad de pasar la criba automática. Este tipo de sesgos se incorpora durante el desarrollo del modelo, por lo que se debe formar a los equipos de científicos de datos a identificar en los datos, posibles elementos de riesgo y contrarrestarlos, en el caso de ejemplo de los CVs, tan solo se tendría que balancear el número de mujeres y hombres para que el algoritmo no lo considerase como un factor decisivo.

- Hacer un modelo de concesión automática de créditos al consumo. Este modelo en principio no debería tener problemas éticos ya que conocemos históricamente las características de los pagadores y podemos estimar de forma sencilla la probabilidad de impago. Pero si entrenamos a un modelo con datos de concesión / no concesión de crédito que vienen de la decisión de un analista de riesgos que siempre denegaba el crédito a un código postal concreto, estaríamos de facto incorporando ese sesgo humano en el modelo y por tanto automáticamente se denegaría el crédito a un cliente de ese código postal (al igual que hacia el humano). Este sesgo hay que identificarlo y de nuevo corregirlo antes de construir el modelo.

En este caso, la conclusión que nos remarca Sanz es «el modelo que estés construyendo, debes cerciorarte de que no exista sesgo ni que incluyes sesgos en los modelos.»