Google sigue sacando herramientas de Inteligencia Artificial. En estas dos últimas semanas Google ha anunciado varias herramientas nuevas para ayudar con la Inteligencia Artificial o Machine Learning.

Ahora nos trae un nuevo lanzamiento, Cloud AI Platform Pipelines, un servicio diseñado para implementar una robusta IA con monitoreo, auditoría, seguimiento de versiones y reproducibilidad en la nube. Google lo presenta como algo «fácil de instalar» para los flujos de trabajo de aprendizaje automático, lo que podría reducir la cantidad de tiempo que las empresas dedican a llevar productos a producción.

«Cuando solo está creando prototipos de un modelo de aprendizaje automático en una computadora portátil, puede parecer bastante sencillo. Pero cuando necesita comenzar a prestar atención a las otras piezas necesarias para que un flujo de trabajo de aprendizaje automático sea sostenible y escalable, las cosas se vuelven más complejas”, escribió Anusha Ramesh la gerente de producto de Google y Amy Unruh, la Staff Developer, en una publicación en el blog de la compañía. “Un flujo de trabajo de aprendizaje automático puede implicar muchos pasos con dependencias entre sí, desde la preparación y el análisis de datos, hasta la capacitación, la evaluación, la implementación y más. Es difícil componer y rastrear estos procesos de manera ad-hoc, por ejemplo, en un conjunto de cuadernos o scripts, y cosas como la auditoría y la reproducibilidad se vuelven cada vez más problemáticas«.

La plataforma, AI Platform Pipelines, tiene dos partes principales:

- La infraestructura para implementar y ejecutar flujos de trabajo de IA estructurados que están integrados con los servicios de Google Cloud Platform.

- Las herramientas de canalización para construir, depurar y compartir las fuentes de información y los componentes.

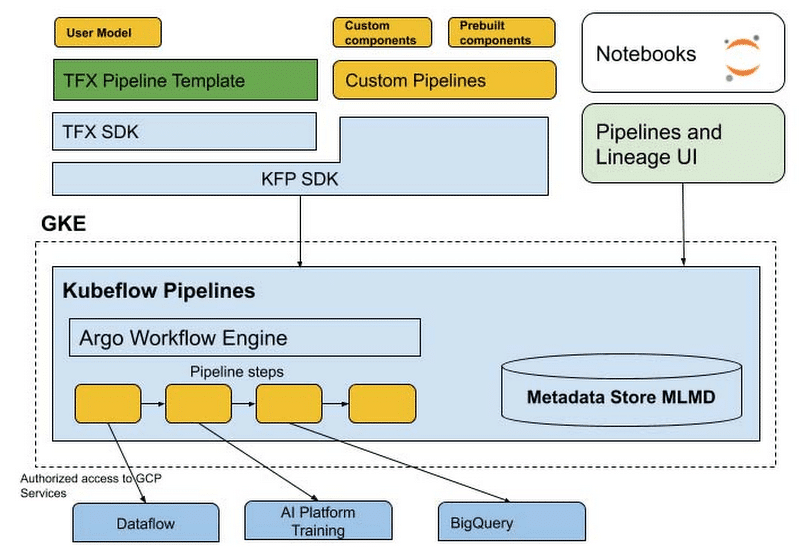

El servicio se ejecuta en un clúster de Google Kubernetes que se crea automáticamente como parte del proceso de instalación, y es accesible a través del panel de la plataforma Cloud AI. Con AI Platform Pipelines, los desarrolladores especifican una fuente de información usando el kit de desarrollo de software (SDK) de Kubeflow Pipelines, o personalizando la plantilla de fuentes de información de TensorFlow Extended (TFX) con el SDK TFX. Este SDK compila las fuentes de información y lo envía a Pipelines REST API server, que almacena y programa las fuentes de información para su ejecución.

AI Pipelines utiliza el motor de flujo de trabajo Argo de código abierto para ejecutar la fuente de información y tiene microservicios adicionales para registrar metadatos, manejar componentes IO y programar ejecuciones de canalizaciones. Las fuentes de información se ejecutan como módulos aislados individuales en un clúster y cada componente puede aprovechar los servicios de Google Cloud, como Dataflow, entrenamiento y predicción de plataformas de IA, BigQuery y otros. Mientras tanto, pueden contener pasos que realizan el cálculo de la tarjeta gráfica y la unidad de procesamiento del tensor en el clúster, aprovechando directamente características como el autoescalado y el autoaprovisionamiento de nodos.

Las ejecuciones de AI Platform Pipeline incluyen el seguimiento automático de metadatos utilizando ML Metadata, una biblioteca para registrar y recuperar metadatos asociados con el desarrollador de aprendizaje automático y los flujos de trabajo de científicos de datos. El seguimiento automático de metadatos registra los artefactos utilizados en cada paso de fuentes de datos, los parámetros de la fuentes y el enlace a través de los artefactos de entrada / salida, así como los pasos que los creó y consumió.

Además, AI Platform Pipelines admite el control de versiones de canalización, lo que permite a los desarrolladores cargar varias versiones de la misma canalización y agruparlas en la interfaz de usuario, así como el seguimiento automático de artefactos y linajes. El seguimiento nativo de artefactos permite el seguimiento de cosas como modelos, estadísticas de datos, métricas de evaluación de modelos y muchos más. Y el seguimiento de linaje muestra el historial y las versiones de sus modelos, datos y más.

En el blog de Google dicen que en el futuro cercano, AI Platform Pipelines obtendrá un aislamiento multiusuario, lo que permitirá que cada persona que acceda al control de clúster de Pipelines pueda acceder a sus tuberías y otros recursos. Otras características futuras incluyen la identidad de la carga de trabajo para admitir el acceso transparente a los Servicios de Google Cloud; una configuración basada en la interfaz de usuario de almacenamiento fuera del clúster de datos de fondo, incluidos metadatos, datos del servidor, historial de trabajos y métricas; actualizaciones de clúster más simples; y más plantillas para crear flujos de trabajo.