Primero ataca Signal sacando una herramienta para desenfocar las caras, y que no puedan reconocerse. Después, en la Universidad de Duke encuentran una tecnología para volver a enfocar esas caras.

Todavía nadie ha hablado de que la nueva tecnología desarrollado por la Universidad de Duke pueda enfocar las caras que se desenfocan con la herramienta de Signa, pero es muy probable que esto pueda suceder.

Signal busca medidas contra el reconocimiento facial

Hace unos días Signal anunciaba que su aplicación de mensajería cifrada incluiría una nueva herramienta para desenfocar las caras en videos. Esto agregaba una capa de privacidad a las imágenes, aunque no necesariamente significa que la persona se vuelva irreconocible.

La actualización la presentó el cofundador de Signal Moxie Marlinspike vinculándola con las protestas contra el racismo y la violencia policial provocadas por el asesinato de George Floyd.

Una cosa inmediata parece clara: 2020 es un año bastante bueno para cubrirte la cara. Moxie Marlinspike

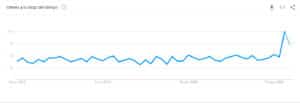

El medio digital Vox publicó un artículo en el que hablaba del aumento de descargas que estaba teniendo la aplicación en Estados Unidos durante las últimas semanas, correspondiendo con el anunció de la actualización.

La función de desenfoque es un muy fácil de utilizar. Cuando tomas una foto o un video a través de Signal y seleccionas la opción desenfocar en la barra de herramientas, la aplicación detectará automáticamente las caras que aparecen y las desenfoca. Puede que algunas de las caras no se detecten, por es, la aplicación te permite que las desenfoques manualmente.

Las medidas de Signal reciben el ataque de la Universidad de Duke

La Universidad de Duke ha desarrollado un sistema de Inteligencia Artificial que permite conseguir una imagen de gran definición de un retrato difuso.

Funciona buscando a través de imágenes generadas por Inteligencia Artificial en HD una que se parezca a la imagen de entrada cuando se ha comprimido al mismo tamaño. «El equipo utilizó una herramienta en el aprendizaje automático llamada «red adversaria generativa», o GAN, que son dos redes neuronales entrenadas en el mismo conjunto de datos de fotos. Una red viene con rostros humanos creados por IA que imitan los que fue entrenado, mientras que la otra toma esta salida y decide si es lo suficientemente convincente como para ser confundido con la cosa real. La primera red mejora con experiencia, hasta que la segunda red no pueda notar la diferencia.«, así explican el sistema en el Duke Today.

El equipo ha afirmado que se puede obtener una imagen 60 veces más nítida que la original.